提供令人生畏的能源需求

说到技术趋势,人工智能将是2023年的流行语,未来十年也可能如此。有一家公司有望在这个市场上产生影响,那就是英伟达——它制造可以同时处理多个计算的先进GPU技术能够很好地转移到人工智能系统中。英伟达的股票价值在2023年上半年惊人地上涨了185%。

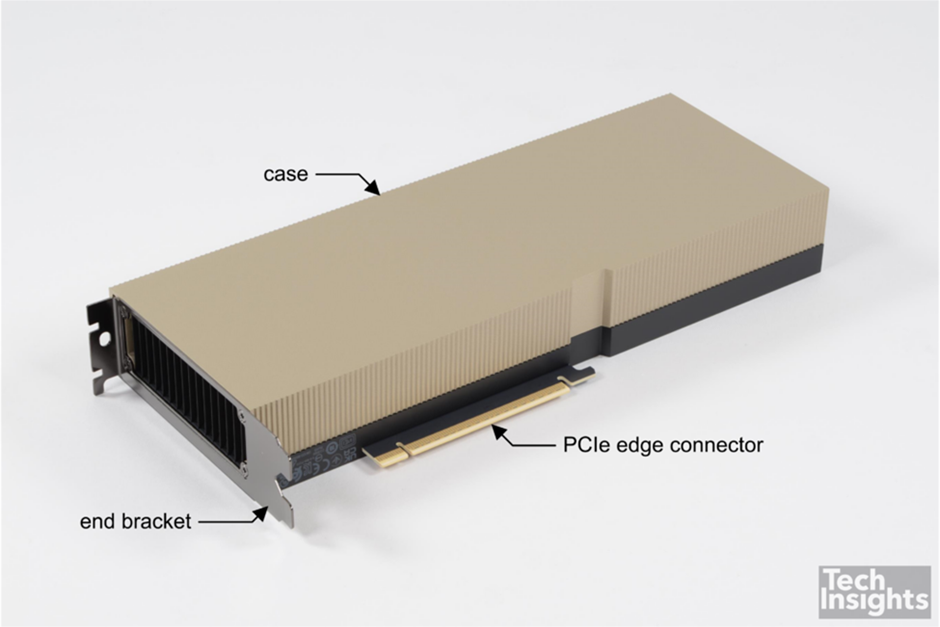

基于英伟达 Hopper架构的英伟达 H100张量核心(tensor core)GPU最近引起了很多关注。TechInsights获得了该技术的PCIe版本(见图1)。关于GPU架构对人工智能处理和神经网络的适用性,其他地方已经写了很多文章;关于Hopper架构的一篇特别有趣的文章可以在TechInsights发布的微处理器报告《Nvidia Hopper Leaps Ahead》[1]中找到。

图1:英伟达 H100 PCIe加速卡

人工智能应用对功率需求是极高的,在本篇文章中,我们将解决具体的问题——是什么为这种尖端产品提供了功率需求?

如何安全地提供超过一兆瓦的功率

英伟达在2022年3月的春季“GTC”活动[2]上发布的H100芯片证实,SXM5版本的热设计功率(TDP)高达700 W (PCIe高达350 W),专为空气和液体冷却而设计。

虽然PCIe是一个更“标准”的接口,但SXM是英伟达自己设计的高带宽插座。英伟达 DGX H100服务器[3]是为8个加速卡而设计的,因此功率超过5千瓦。

英伟达 DGX SuperPOD架构采用英伟达的NVLink和NVSwitch系统,最多可连接32个DGX节点,共256个H100 GPU。这是一个真正的人工智能基础设施平台;英伟达的DGX SuperPOD数据中心设计[4]让我们对真正的企业人工智能基础设施的巨大功率和冷却需求有了一些了解。

每台DGX H100服务器(8个GPU)的最大功率为10.2 kW,建议风冷以保持工作温度在5 ~ 30℃。对于一个完整的32节点SuperPOD,无论机架配置如何,总功率需求为326.4 kW(不包括管理机架、存储等的额外功率)。总预期峰值功率为1.3 MW,峰值热负荷为4.42 MBTU/h,需要的最小气流为4.445 m3/分钟。

一兆瓦是很大的能量。在这篇“free energy[5]”的文章中可以找到一些关于兆瓦时的有趣背景。它可以为普通美国家庭提供1.2个月的电力,也就是说,可以得出一个粗略的等效-运行一个功率需求为326.4千瓦的SuperPOD一天多一点(30小时)可以为普通美国家庭提供一年的电力。在这些功率水平上,功率转换效率的百分比改进可以对冷却要求和环境后果产生重大影响。这就是氮化镓(GaN)器件在数据中心功率网络中产生巨大影响的原因。

每个服务器以及随后的每个电路板的功率配置和分配非常复杂,在SuperPOD数据中心设计参考指南的第3章中有详细介绍。简而言之,功率分配单元中的每个机架将DGX H100的三相输入电源分为三个单独的单相电路。然后,这将进一步下放到电路板层面。

来自: TechInsights

更多阅读: