全球市场研究机构TrendForce集邦咨询观察,2024年大型云端CSPs,如Microsoft、Google、Meta、AWS等厂商,将仍为采购高阶主打训练用AI server的主力客群,以作为LLM及AI建模基础。待2024年CSPs逐步完成建置一定数量AI训练用server基础设施后,2025年将更积极从云端往边缘AI拓展,包含发展较为小型LLM模型,以及建置边缘AI server,促其企业客户在制造、金融、医疗、商务等各领域应用落地。

此外,因AI PC或NB在计算机设备基本架构组成与AI server较为相近,具有一定程度运算能力、可运行较小型LLM及GenAI等运用,有望成为CSPs连接云端AI基础设施及边缘AI小型训练或推理应用的最后一里路。

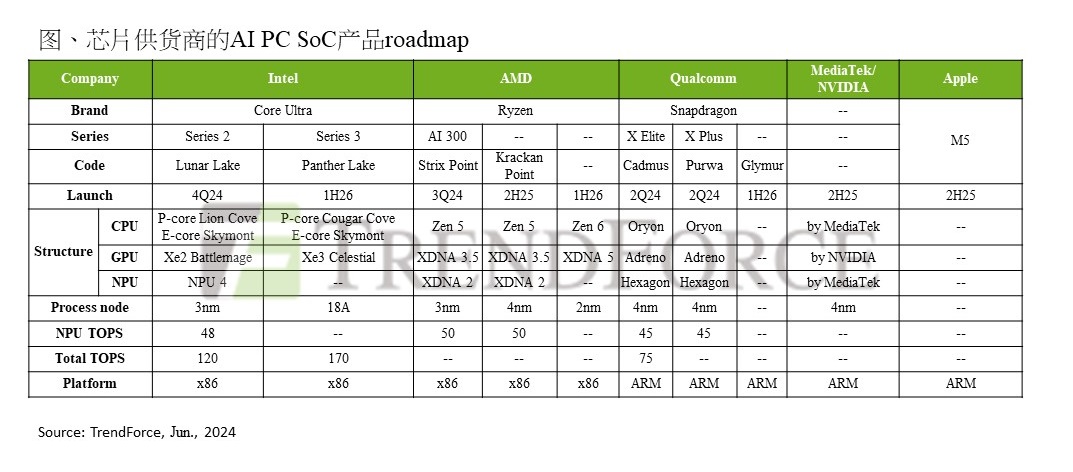

观察近期芯片厂在AI PC的布局,Intel的Lunar Lake及AMD的Strix Point都是在本月COMPUTEX展会首次发布的SoC,并都符合AI PC标准,故尽管Lunar Lake及Strix Point所配套的PC机种分别预计于今年第四季及今年第三季才上市,PC OEM会场工作人员仅以口头说明该两类机种的规格表现,但该两款SoC及所搭载的PC机种仍为活动中市场主要关注焦点。

在品牌端,ASUS及Acer继5月推出搭载Qualcomm Snapdragon X Elite的机种后,也在COMPUTEX展会期间推出搭载Lunar Lake、Strix Point的机种,MSI仅推出搭载Lunar Lake、Strix Point的机种;新款AI PC建议售价落于US$1,399-1,899区间。

TrendForce集邦咨询认为,2025年随着AI应用完善、能处理复杂任务、提供更好的用户体验并提高生产力,将带动消费者对于更智能、更高效的终端设备需求迅速增长,AI NB渗透率将快速成长至20.4%的水位,预期AI NB浪潮亦将带动DRAM Content增长。

TrendForce集邦咨询预估,NB DRAM平均搭载容量将自2023年的10.5GB年增12%至2024年的11.8GB。展望2025年,随AI NB渗透率自2024年的1%提升至2025年的20.4%,且AI NB皆搭载16GB以上DRAM,将至少带动整体平均搭载容量增长0.8GB,增幅至少为7%。

TrendForce集邦咨询认为,AI NB除了带动NB DRAM平均搭载容量提升外,还将带动省电、高频率存储器的需求。在这种情况下,相较于DDR,LPDDR更能凸显其优势,因而加速LPDDR替代DDR的趋势。对原本追求可扩展性的DDR、SO-DIMM方案而言,转换至同属模块的LPDDR、LPCAMM方案亦为LPDDR on board之外的选项之一。

更多阅读: